I EFTERÅRET 2019 BEGYNDTE TAREK GHANOUM som studentermedhjælper i en styrelse under Beskæftigelsesministeriet, og noget af det første, han hørte om sin nye arbejdsplads, var, at den diskriminerede mod etniske minoriteter. “Det kom virkelig bag på mig, for jeg var lige begyndt derinde,” siger han.

Tarek Ghanoums nye arbejdsplads var Styrelsen for Arbejdsmarked og Rekruttering, også kendt som STAR, og snakken om diskrimination handlede om en algoritme, styrelsen har udviklet. Når en borger melder sig ledig på Jobnet.dk, bliver man opfordret til at besvare et spørgeskema inden den første samtale på jobcenteret. Algoritmen tager de svar, kører det sammen med personlige oplysninger om den ledige, og ud kommer en forudsigelse om den lediges risiko for at blive langtidsledig.

På Facebook havde Tarek Ghanoum læst om et sammenstød, en ung kvinde ved navn Telli Betül Karacan havde haft med STAR-algoritmen. Hun havde afsluttet sine statskundskabsstudier og meldt sig ledig på Jobnet.dk. Her udfyldte hun spørgeskemaet, svarede på spørgsmål som ‘Hvad er din højeste gennemførte uddannelse’, og ‘Hvor hurtigt tror du, at du får et arbejde’. I baggrunden bedømte algoritmen hendes risiko for at gå ledig det næste halve år. Altså en forudsigelse om hendes fremtid. Og som hun besvarede spørgsmålene, så hun, at hendes etnicitet indgik i profileringen. ‘Efterkommer af ikke-vestlig indvandrer’, stod der. “Hvorfor er det en relevant information, når jeg har dansk statsborgerskab?” spurgte hun på Twitter.

Tweetet gik viralt, og brændslet var forargelse: “Skal vi også tage borgernes vægt, seksualitet og religion med i vurderingerne?” som hun spurgte i Politiken. Tarek Ghanoum fulgte debatten inde fra STAR. Han forhørte sig blandt sine nye kolleger. “Jeg spurgte, hvor vigtig herkomst egentlig er i den endelige bedømmelse,” siger han. Meget, lød svaret. Men det var der god grund til, beroligede styrelsens ansatte, for statistikken siger, at etniske minoriteter har større risiko for langtidsledighed. Altså er der god grund til at tage herkomst med i bedømmelsen, så jobcenteret kan hjælpe dem så godt som muligt.

På sin Facebook-profil skrev Tarek Ghanoum et forsvar for algoritmen. “Vi kan selvfølgelig ændre det fra vestlig/ikke-vestlig til EU/ikke-EU og meget andet, men det ændrer ikke på, at variablen ‘herkomst’ har en statistisk betydning.” Men da han et år senere skulle skrive speciale, fik han mulighed for selv at granske STAR-algoritmen. Specialet afleverede han for nylig, og det, Tarek Ghanoum har opdaget, har fået ham til at trække sit forsvar tilbage.

Læs Tarek Ghanoums Facebook-tekst her.

Læs interviewet i Politiken her.

SIDEN 2015 HAR STAR’S ALGORITME PROFILERET nyledige dagpengemodtagere over hele landet. Op mod 150.000 mennesker om året. Og formålet synes nobelt: Når profileringen er ovre, får den ledige at vide, at vejen ind på arbejdsmarkedet enten bliver nem eller svær for sådan en som dig, og samme besked får den lediges jobrådgiver. Men algoritmen har længe været en af de mest omdiskuterede teknologier, det offentlige Danmark har sluppet løs på borgerne.

Vi har fået aktindsigt i algoritmens indmad, altså de beregninger, der afgør, om en ledig spås en risiko for langtidsledighed eller ej, og kan se, at herkomst ikke blot indgår i forudsigelsen, men har afgørende indflydelse på, at etniske minoriteter får risiko-stemplet. For etniske danskere er det til gengæld jobsøgerens alder, som algoritmen bruger til at bedømme risikoen for langtidsledighed. “Forskning viser, at der er diskrimination på arbejdsmarkedet, etnisk og aldersdiskrimination, og STAR’s algoritme genskaber det,” mener Vedran Sekara, adjunkt på IT-Universitetet og ekspert i kunstig intelligens. STAR har afvist et interview, men skriver i en mail, at algoritmen er et “frivilligt værktøj, nyledige får” på Jobnet.dk, der “siger noget om, om borgere, der lignede denne borger, havde svært ved at finde et arbejde”.

Med Tarek Ghanoums speciale kan vi også se, at algoritmens spådomme har betydning for ledige med minoritetsbaggrund. Han kan påvise, at etniske minoriteter bliver indkaldt til langt flere samtaler på jobcenteret end etniske danskere. Positiv særbehandling, kalder en jobcenterleder det. Andre jobrådgivere oplever stemplingen som diskriminerende. “Du skal forestille dig,” siger Tarek Ghanoum, en jobrådgiver fortalte ham, “at du lige har fået 12 i dit afgangsprojekt, du har energi til at komme ud og arbejde – og det første, du får at vide, er, at du er risikogruppen. Det er demotiverende.”

Det her er en afgørende diskussion at få styr på. I takt med at staten tager flere og flere algoritmer i brug i sagsbehandling, vil vi igen og igen stå i dette dilemma: Hvad skal persondata have af betydning for det enkelte menneskes liv og for, hvordan det menneske bliver behandlet af det offentlige? Statistikken siger, at hvis du har indvandrer- eller efterkommerbaggrund, så har du det sværere på arbejdsmarkedet. Men hvordan skal den viden bruges, og kan man overhovedet bruge statistik om tusindvis af mennesker til at sige noget om ét menneskes skæbne? I virkeligheden hviler STAR-algoritmen på ét spørgsmål: Hjælper algoritmen den ledige med minoritetsbaggrund ved at give ham eller hende ekstra opmærksomhed? Eller er algoritmen diskriminerende?

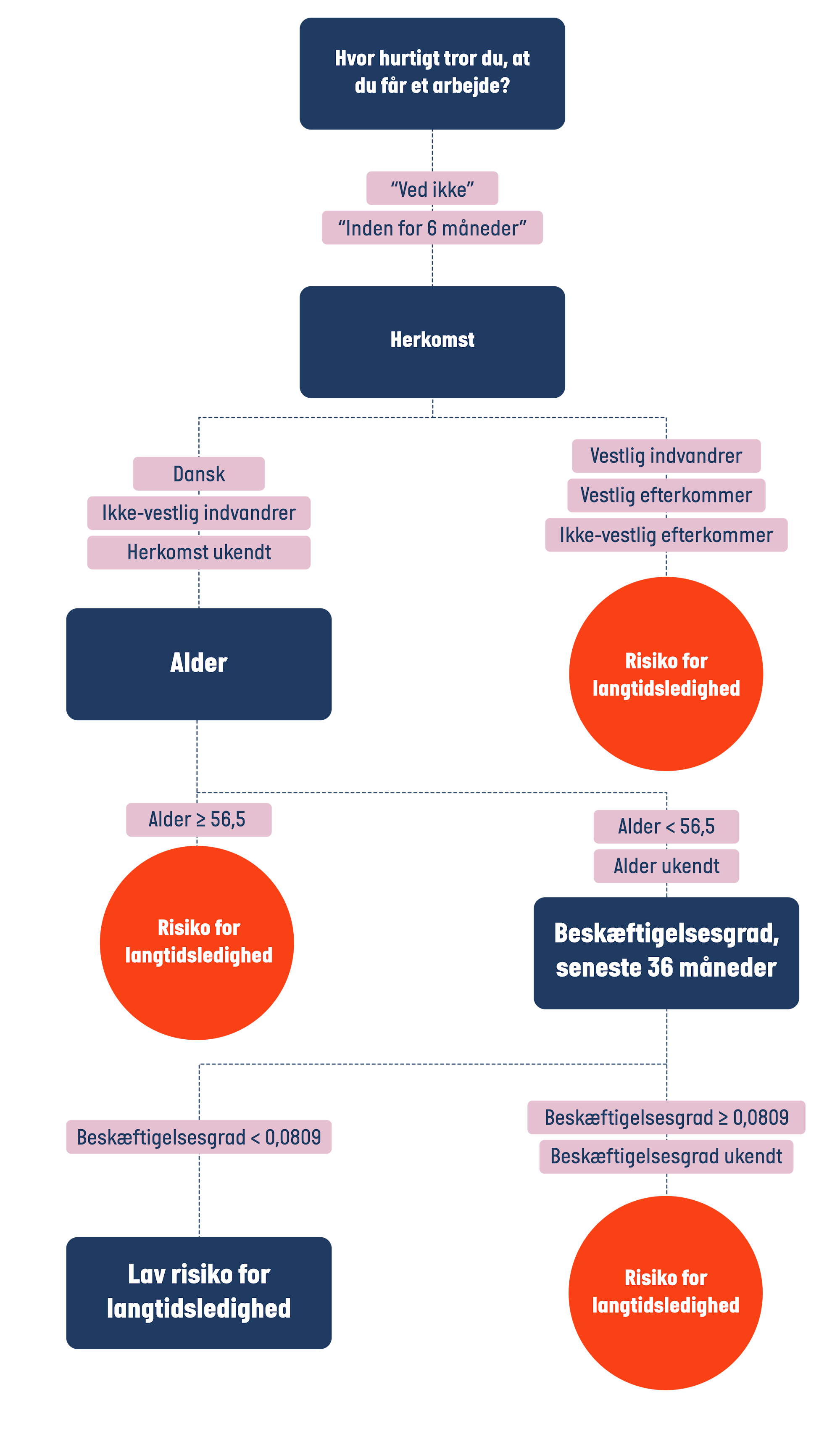

SKILLER MAN STAR’S ALGORITME AD, OPDAGER MAN hurtigt, at der er tale om en af de mest simple typer algoritmer, et såkaldt beslutningstræ. Hvor en algoritme ofte vil vægte svimlende mange oplysninger op mod hinanden, før den træffer en beslutning, minder STAR’s beslutningstræ mere om den måde, vi mennesker beslutter os for at, lad os sige, spise koldskål: Er det sommer? ‘Ja.’ Kan jeg piske en koldskål? ‘Ja.’ Har jeg kammerjunkere i skabet? ‘Ja.’ Fedt, så spiser jeg koldskål.

Men som du ser, hviler hele beslutningen om at spise koldskål på, om det er sommer. Er det ikke det, og du derfor svarer ‘nej’, er det ligegyldigt, at du kan piske en koldskål og har kammerjunkere i skabet– dét at det ikke er sommer, gør dine køkkenfærdigheder, og hvad end du måtte have i skabet, irrelevant: Det er ikke sommer, ergo skal du ikke spise koldskål. Det er en vigtig pointe, fordi den beslutningsproces gør, at beslutningstræet, som STAR’s algoritme bruger til at spå lediges risiko for langtidsledighed, ligeledes hviler på meget få oplysninger om den ledige – og at blot én oplysning om den ledige kan gøre alle andre oplysninger irrelevante.

Når STAR’s algoritme bedømmer en ledigs risiko for langtidsledighed, sker det ud fra en til fire oplysninger. Hvis du tænker, det virker som få oplysninger om et menneske, har du ret. I hvert fald når man forudsiger det menneskes muligheder på arbejdsmarkedet. Hvad vildere er, kun én af oplysningerne går rent faktisk på den lediges erhvervserfaring. Det er dog langtfra den vigtigste oplysning. Det er i stedet den lediges egen vurdering af, hvornår de får et job. Svarer man snart eller inden for tre måneder, ser algoritmen bort fra alle øvrige oplysninger om den ledige. Den ledige er ikke i risiko for lang ledighed, beslutter den. I praksis betyder det, at algoritmens vurdering alene er en bekræftelse af den lediges egen vurdering. Ikke ligefrem raketvidenskab.

Samme bekræftelse sker, hvis den ledige ikke synes, han eller hun har udsigt til et job, men svarer, at der går mere end seks måneder, eller svarer, at man forventer at gå på barsel, efterløn eller pension. Så ser algoritmen også bort fra alle andre oplysninger, og man spås risiko for langtidsledighed. Og så når vi den sidste og måske mest kontroversielle gruppe: Dem, der svarer ‘ved ikke’ til, hvornår de får et job, eller ‘inden for seks måneder’. For den gruppe er ‘herkomst’ dén oplysning, der afgør algoritmens spådom.

Er man indvandrer eller efterkommer fra et vestligt land eller efterkommer fra et ikke-vestligt land som Telli Betül Karacan eksempelvis, mener algoritmen, man har en statistisk større risiko for langtidsledighed end andre. Det er uanset ens uddannelsesniveau, erhvervserfaring og øvrige oplysninger. Det er ligegyldigt – den lediges herkomst gør alt andet irrelevant. Men er den lediges herkomst dansk eller ikke-vestlig indvandrer, er alderen den afgørende faktor. Er man over 56,5 år, får man risiko-stemplet. Er man under, afgør ens beskæftigelsesgrad de seneste tre år udfaldet. Har man arbejdet meget, spås man ingen risiko – har man arbejdet lidt, er man i risiko. Det er altså først i bunden af beslutningstræet, at den lediges karriere har indflydelse på forudsigelsen. Og forklaringen på, hvorfor det er sådan, er lige så kontroversiel som konsekvenserne af det.

Her har vi illustreret den gren i beslutningstræet for gruppen, hvor herkomst og alder har afgørende indflydelse på risikobedømmelsen

FORKLARINGEN PÅ, AT 56-PLUSSERE OG etniske minoriteter falder negativt ud i STAR’s forudsigelse, er, at det har algoritmen lært af sig selv. Den statslige styrelse har nemlig trænet algoritmens viden på omkring 152.000 dagpengemodtagere, altså deres alder, køn, herkomst og så videre, og disses besvarelser af spørgeskemaet på Jobnet.dk. I træningen har algoritmen fundet frem til, at en høj alder og minoritetsbaggrund statistisk set hænger sammen med lang ledighed. Men i den konklusion skjuler der sig forskelsbehandling, mener Vedran Sekara fra IT-Universitetet.

Undersøgelser har vist, at jobansøgere med mellemøstlige navne skal sende langt flere ansøgninger end ansøgere med traditionelle danske navne, selv om ansøgerne har samme erfaring og kvalifikationer, og at det ligeledes er sværere for ældre at få job. Den slags forskelsbehandling er ulovlig i Danmark, men alligevel tyder det på at være en faktor som ledig. Og STAR’s algoritme, mener Vedran Sekara, opretholder den forskelsbehandling. “Algoritmen noterer, at du er gammel, eller at din herkomst er en anden end dansk, og konkluderer: så er du i højrisikogruppen. Men det skyldes måske også et arbejdsmarked, der forskelsbehandler ledige ældre og etniske minoriteter.”

Men man kan også indvende, at der slet ikke er tale om diskrimination, men positiv særbehandling. STAR-algoritmen gør netop dem, der statistisk set har udfordringer på arbejdsmarkedet, opmærksom på den virkelighed, de er på vej ud i – og fordi jobrådgiveren også læser risiko-spådommen forud for den første samtale, kan de også yde ekstra støtte. Det var det, Tarek Ghanoums kolleger i styrelsen argumenterede for. Og da han så skulle skrive speciale, forsøgte han at finde ud af, hvad dataene og jobcentrene selv sagde. Og han fandt en ret vild forskel.

DA DEBATTEN OM STAR’S INDDRAGELSE AF lediges herkomst var på sit højeste i 2019, mente Institut for Menneskerettigheder, at det var decideret lovstridigt. “At lægge vægt på ikke-vestlig etnisk herkomst i sagsbehandlingen af den enkelte borger er diskrimination, medmindre der er tale om positiv særbehandling,” lød det. Den sidste sætning fangede Tarek Ghanoums nysgerrighed, og han satte sig for at teste det med en hypotese: Bliver ledige med indvandrer- eller efterkommerbaggrund indkaldt til flere samtaler på jobcenteret end etnisk danske ledige? Hvis de gjorde, kunne det være forskelsbehandling, men måske den positive af slagsen.

For at undersøge hypotesen har han sammenlignet to grupper af tidligere ledige. Eneste forskel på grupperne er herkomst. Den ene er efterkommere, den anden etnisk dansk. Men derudover var alle færdiguddannede, havde samme sprogfærdigheder, modtog samme ydelser og boede i samme by. Og så kiggede Ghanoum på, hvor mange samtaler hver gruppe var blevet indkaldt til, før de fik job. Resultatet? “Forskellen er tydelig,” siger han. “Når jeg ser på dataen, ser jeg på antallet af samtaler, de ledige bliver indkaldt til, og der kan jeg med ret stor sikkerhed sige, at der er flere samtaler for efterkommere sammenlignet med etniske danskere.” Særligt i storbykommunerne er forskellen stor. I Odense er mandlige efterkommere til otte flere samtaler på jobcenteret end etnisk danske mænd, og på Frederiksberg er kvindelige efterkommere til syv flere samtaler.

“Man tænker virkelig, at man hjælper de her folk ved at indkalde dem til flere samtaler,” siger Ghanoum, der har interviewet jobrådgivere fra forskellige kommuner. Men, siger han, “som efterkommer kan jeg også godt se ekstra samtaler som en byrde på mine skuldre.” Særligt hvis forklaringen er, at STAR har vurderet ham i højrisiko ud fra herkomst, mens uddannelsesniveau, sprogkundskaber og erhvervserfaring ingen indflydelse har. “Min herkomst kan jeg jo ikke ændre på.”

Tarek Ghanoum kan ikke svare på, om det højere antal samtaler, som etniske minoriteter indkaldes til, skyldes længere ledighedsforløb. Altså om de simpelthen bare har flere samtaler, fordi de følger statistikken for ledige med anden etnisk baggrund end dansk og er ledige i længere tid. “Det findes der ikke nok data til at sige med sikkerhed,” siger han. I specialet interviewer han en leder på Jobcenter Frederiksberg. Lederen forklarer, at ledige, der spås i risiko for langtidsledighed af STAR-algoritmen, indkaldes til to månedlige samtaler i stedet for den ene, ledige skal til. I sit speciale citerer Ghanoum jobcenterchefen for, at det højere antal samtaler ikke er udtryk for forskelsbehandling, men positiv særbehandling. Eksempelvis ved at tilbyde et kursus, hvor man lærer at skrive et godt cv.

I 2019 forsvarede Ghanoum inddragelsen af herkomst – det gav statistisk mening, skrev han på Facebook – men hvad med i dag? “Det er sjovt, fordi jeg er faktisk lige blevet ledig efter at have afleveret speciale.” Derfor har han tænkt over, om han vil lade sig risikovurdere på Jobnet.dk. “Men jeg ved, jeg begynder i arbejde til august. Og da den vigtigste faktor er, hvad man selv vurderer – om man tror, man snart kommer i job – vil mit svar nok være meget positivt. Men omvendt ved jeg også, hvor meget min herkomst fylder i vurderingen. Derfor har jeg besluttet at springe over.”